Gerhard Schreiber beschreibt, wie sich Theologie und Kirche durch KI-Textgeneratoren verändern könnten.

„Der menschenwürdige Sinn der Computers wäre es, das Denken der Lebendigen so sehr zu entlasten, daß es Freiheit gewinnt zu dem nicht schon impliziten Wissen.“[1] Dieser von Theodor W. Adorno vor beinahe 60 Jahren in einem Rundfunkvortrag geäußerte Gedanke über den Umgang mit „kybernetischen Maschinen“[2] scheint wie in unsere Zeit gefallen. Eine Zeit, die von immer neuen Entwicklungen im Bereich der Digitaltechnologien überrannt wird. Eine Zeit, in der dem Menschen allerorten zuvor ungeahnte Möglichkeiten aufgetan werden, auf Errungenschaften im Bereich der Künstlichen Intelligenz (KI) zurückgreifen zu können. Eine Zeit, in der Visionen realisiert und Realitäten visioniert werden, die nichts Geringeres darstellen als eine digitale Revolution der Denkungsart: sich seines eigenen Verstandes nicht ohne Anleitung künstlicher neuronaler Netze zu bedienen. Ein Gewinn an Freiheit, der sich – fataler Beigeschmack – als selbstverschuldeter Verlust an Mündigkeit zu entpuppen droht.

Keine Plagiate, sondern Unikate

In diesem Spannungsfeld zwischen dystopischen Schreckensvisionen und eutopischen Zukunftsversprechen bewegt sich auch die Frage nach dem Umgang mit KI-Textgeneratoren. Vereinfacht gesagt handelt es sich dabei um Computerprogramme, die wie von Menschenhand geschriebene Texte produzieren können. Solche Programme, deren Existenz durch den Hype um den Ende November 2022 veröffentlichten Chatbot ChatGPT der breiten Öffentlichkeit bekannt wurde, nutzen die erwähnten neuronalen Netze. Diese lernen aus unfassbar großen Datenmengen Muster, um anhand der erlernten Muster auf Basis von Wahrscheinlichkeiten semantisch sinnvolle Wortfolgen zu ‚würfeln‘. Von KI-Textgeneratoren produzierte Texte sind demnach „keine Plagiate, sondern Unikate“[3], womit Fragen der Urheberschaft und Kennzeichnungspflicht von KI-generierten Texten virulent werden.[4]

Die Rolle des Menschen beschränkt sich in diesem Setting darauf, Anweisungen (prompts) zu geben, die als Eingaben (inputs) in Textform dem KI-System mitteilen, was es generieren soll. Dies können einfache Stichworte (z.B. „Bochum“) oder ganz konkrete Aufgabenbeschreibungen sein (z.B. „Schreibe eine 15-minütige Predigt über 1. Johannes 1, 1-4 für eine katholische Gemeinde in Baden-Württemberg. Beginne mit einem aktuellen Einstieg und schließe mit einem passenden Zitat von Papst Franziskus. Erbaulicher Stil, mittendrin auch mal ein Witz“). Bei der sogenannten Conversational AI, wie sie auch bei ChatGPT oder dem Bing-Chatbot zum Einsatz kommt, erfolgt die Textgenerierung im Rahmen einer Mensch-Maschine-Interaktion, die ein „natürliches“ Gespräch simulieren soll und es dem Menschen ermöglicht, maschinengegebene Antworten als Ausgangspunkte für Nach- und Weiterfragen zu nutzen. Auf diese Weise kann sich eine kohärente Konversation entspinnen, wie sie – so die Zielsetzung – auch mit einem menschlichen Gegenüber geführt werden könnte.

Entschiedene Maßnahmen zur Schaffung größtmöglicher Transparenz

Es liegt auf der Hand, dass KI-Textgeneratoren nicht nur für die Zukunft ganzer Berufsgruppen in der Werbe-, Medien- und Kommunikationsbranche,[5] sondern auch für Forschung und Wissenschaft von nicht zu unterschätzender Bedeutung sein werden. Im Zeitalter des Publish or Perish (‚publiziere oder gehe unter‘) und der wissenschaftlichen Erfolgsmessung anhand des Forschungsoutputs in einer durch Bibliometrie (Stichwort: Impact Factor[6]) und Altmetrik[7] vermessenen Publikationslandschaft würde ein konsequenter Verzicht auf KI-gestützte Werkzeuge einen entscheidenden – selbstauferlegten – Nachteil im wissenschaftlichen Wettbewerb um Forschungsgelder und Stellen bedeuten. Es ist daher davon auszugehen, dass der Einsatz KI-gestützter Werkzeuge bei der Erstellung, Übersetzung und Überarbeitung von Texten bald ebenso selbstverständlich sein wird wie die Nutzung von Systemen zur erleichterten Texteingabe auf Smartphones oder herkömmlicher integrierter Programme zur Rechtschreib- und Grammatikprüfung.

Im Zuge der Weiterentwicklung von KI-Textgeneratoren und der gezielten Ausweitung der ihnen zugrunde liegenden Trainingsdaten auch auf qualitativ hochwertige Fachpublikationen wird daher jede wissenschaftliche Textarbeit dem hermeneutischen Verdacht der Generierung ausgesetzt sein, wenn dem nicht durch entschiedene Maßnahmen zur Schaffung größtmöglicher Transparenz entgegengewirkt wird. Trotz aller zu befürchtenden bzw. sich bereits abzeichnenden problematischen Nutzungsweisen KI-gestützter Werkzeuge können diese aber durchaus sinnvoll zur Unterstützung der klassischen Textproduktion eingesetzt werden. In diesem Sinne können Computer, um auf den eingangs zitierten Gedanken Adornos zurückzukommen, durchaus dazu beitragen, das menschliche Denken von Routineaufgaben zu entlasten. Es könnte Freiraum für eigenständiges Denken geschaffen werden, das für Adorno als philosophisches erst dann beginnt, „sobald es sich nicht begnügt mit Erkenntnissen, die sich absehen lassen und bei denen nicht mehr herausschaut, als man schon hineinsteckte“.[8]

KI-Textgeneratoren werden auch in Theologie und Kirche keine Terra incognita bleiben

Eine solche sinnvolle Nutzungsweise von KI-Textgeneratoren scheint mir auch im Kontext von Theologie und Kirche möglich zu sein. Die in ersten Stellungnahmen zu KI-Textgeneratoren im theologischen Bereich auffallende Fokussierung gerade auf deren Schwächen und Schwachstellen („Auf meine allererste Anfrage, ‚Erklär Religion‘, reagierte ChatGPT mit einem Netzwerkfehler“[9]) scheint – wenn nicht Reflex der traditionellen theologischen Skepsis gegenüber digitaltechnologischen Entwicklungen, so doch – Ausdruck eines reflexhaften Bestrebens zu sein, dem Menschlich-Kreativen (irgend)einen prinzipiell uneinholbaren Vorsprung vor dem Maschinen-Generierten sichern bzw. zusichern zu wollen. Einen Vorsprung, der, glaubt man den Ankündigungen der auf KI spezialisierten Unternehmen, nach Überwindung der technologischen Kinderkrankheiten ihrer Produkte schon bald aufgebraucht sein wird. Es gibt jedenfalls nicht den geringsten Grund zu der Annahme, dass KI-Textgeneratoren – ausgerechnet – im Kontext von Theologie und Kirche gleichsam Terra incognita bleiben werden.

Daraus ergeben sich für die Zukunft der theologischen Arbeit mit und an Texten erhebliche Herausforderungen in einem bisher nicht gekannten Ausmaß. Die klassische Textproduktion im Bereich der Theologie wird nicht einfach durch automatisierte Textproduktion ersetzt werden. Und die Nutzung von KI-Textgeneratoren als Inspirations- und Impulsquelle entbindet auch nicht von wissenschaftlicher Redlichkeit, geschweige denn von der Selbstverständlichkeit jeder wissenschaftlichen Quellenarbeit, auch die von Künstlicher Intelligenz gelieferten Daten und Aussagen niemals ungeprüft zu lassen: Die Trainingsdaten können ebenso problematisch[10] wie fehlerhaft sein.

Sie können Texterschließungen niemals ersetzen, aber hilfreich unterstützen

Man darf nicht aus den Augen verlieren: KI-Textgeneratoren sind auf Eloquenz und Kohärenz trainiert, nicht auf Wahrheit und Gewissenhaftigkeit. Sie können den individuellen Lernprozess durch Texterschließung niemals ersetzen, aber hilfreich unterstützen. Sie können niemals predigen, aber bei der Predigtvorbereitung nicht weniger hilfreich sein als der Blick in Predigten anderer oder in Predigthilfen. Es geht also gerade nicht darum, eigenständiges Denken an der Garderobe abzugeben, sondern um die Erweiterung menschlicher Möglichkeiten, auch auf ein Spektrum künstlich intelligenter Helferlein zurückgreifen zu können.

Bei allem Grund zu warnenden und mahnenden Worten und der dringenden Notwendigkeit umfassender Maßnahmen zur allgemeinen Sensibilisierung und Aufklärung über Nutzungs- und Missbrauchsmöglichkeiten KI-gestützter Werkzeuge können diese auch zur Entfaltung menschlicher Kreativität und damit zum Aufordnen und Aneignen von Weltwirklichkeit zum Zwecke gemeinschaftlichen Lebens dienen.

____________

Gerhard Schreiber, Dr. theol., ist Akademischer Rat am Institut für Theologie und Sozialethik der TU Darmstadt und Privatdozent für das Fach Systematische Theologie an der Goethe-Universität Frankfurt. Er ist u.a. Mitglied der Projektgruppe Verantwortungsbewusste algorithmische Entscheidungsfindung in der Arbeitswelt (RADM) des Zentrums verantwortungsbewusste Digitalisierung (ZEVEDI).

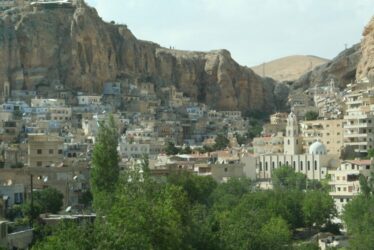

Bild: pixabay

____________

[1] Theodor W. Adorno, Anmerkungen zum philosophischen Denken (Vortrag für den Deutschlandfunk vom 9. Oktober 1964); abgedruckt in: Ders.: Stichworte. Kritische Modelle 2, Frankfurt am Main 1969, 11-19, hier 12 (unter Verwendung der heute nicht mehr gebräuchlichen Pluralform „Computers“).

[2] Ebd. 11.

[3] Peter Salden (u.a.), KI-basierte Schreibwerkzeuge in der Hochschule: Eine Einführung, in: Jonas Leschke/Peter Salden (Hg.): Didaktische und rechtliche Perspektiven auf KI-gestütztes Schreiben in der Hochschulbildung. März 2023 (abrufbar unter: https://doi.org/10.13154/294-9734), 4-21, hier 9.

[4] Für eine erste Einschätzung vgl. Thomas Hoeren, Rechtsgutachten zum Umgang mit KI-Software im Hochschulkontext, in: Ebd., 22-40.

[5] Konstantin Dörr: Algorithmische Werkzeuge – Chancen und Herausforderungen für den Journalismus, in: Klaus Meier/Christoph Neuberger (Hg.): Journalismusforschung. Stand und Perspektiven, Baden-Baden 2023, 203-222; Alexander Filipović: Zur ethischen Bewertung von ChatGPT: Künstliche Konkurrenz?, in: Herder Korrespondenz 77 (2023/3), 29-30.

[6] Christian Fleck: Der Impact Faktor-Fetischismus, in: Leviathan 41 (2013/4), 611-646.

[7] Martina Franzen: Der Impact Faktor war gestern. Altmetrics und die Zukunft der Wissenschaft, in: Soziale Welt 66 (2015/2), 225-242.

[8] Adorno, a.a.O., 11f.

[9] Fabienne Iff: ChatGPT als Religionswissenschaftler?, in: RefLab, 23. Februar 2023; abrufbar unter: www.reflab.ch/chatgpt-als-religionswissenschafter (Zugriff: 18.03.2023).

[10] Zachary B. Wolf: AI can be racist, sexist and creepy. What should we do about it?, in: CNN Politics, 18. März 2023; abrufbar unter: https://edition.cnn.com/2023/03/18/politics/ai-chatgpt-racist-what-matters/index.html (Zugriff: 18.03.2023).